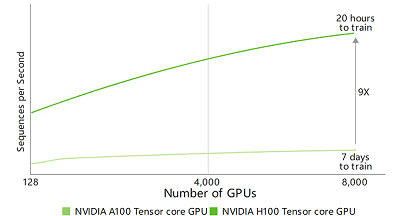

针对大型模型提供高达 9 倍的 AI 训练速度

多专家模型(3950 亿个参数)

预测性能可能会发生变化。基于 1T 令牌数据集训练具有 3950 亿个参数的多专家模型 (MoE) Transformer Switch-XXL 变体 | A100 集群:HDR IB 网络 | H100 集群:NVLink Switch 系统、NDR IB

变革 AI 训练。

H100 配备第四代 Tensor Core 和 Transformer 引擎(FP8 精度),与上一代产品相比,可为多专家 (MoE) 模型提供高 9 倍的训练速度。通过结合可提供 900 GB/s GPU 间互连的第四代 NVlink、可跨节点加速每个 GPU 通信的 NVLINK Switch 系统、PCIe 5.0 以及 NVIDIA Magnum IO™ 软件,为小型企业到大规模统一 GPU 集群提供高效的可扩展性。

在数据中心级部署 H100 GPU 可提供出色的性能,并使所有研究人员均能轻松使用新一代百亿亿次级 (Exascale) 高性能计算 (HPC) 和万亿参数的 AI。

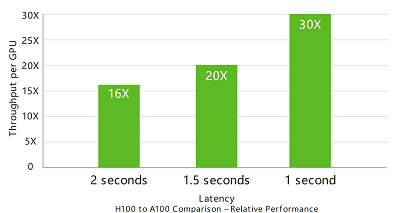

实时深度学习推理。

AI 正在利用一系列广泛的神经网络解决范围同样广泛的一系列商业挑战。出色的 AI 推理加速器不仅要提供非凡性能,还要利用通用性加速这些神经网络。

H100 进一步扩展了 NVIDIA 在推理领域的市场领先地位,其多项先进技术可将推理速度提高 30 倍,并提供超低的延迟。第四代 Tensor Core 可加速所有精度(包括 FP64、TF32、FP32、FP16 和 INT8)。Transformer 引擎可结合使用 FP8 和 FP16 精度,减少内存占用并提高性能,同时仍能保持大型语言模型的准确性。

超大模型的 AI 推理性能提升高达 30 倍。

Megatron 聊天机器人推理(5300 亿个参数)

Projected performance subject to change. Inference on Megatron 530B parameter model chatbot for input sequence length=128, output sequence length=20 | A100 集群:HDR IB 网络 | H100 集群:配置 NDR IB 网络的 16 个 H100 | 32 个 A100 对比 16 个 H100(1 秒和 1.5 秒)| 16 个 A100 与 8 个 H100 的比较(2 秒)

HPC 应用的性能提升高达 7 倍。

预测性能可能会发生变化。3D FFT (4K^3) 吞吐量 | A100 集群:HDR IB 网络 | H100 集群:NVLink Switch 系统、NDR IB | 基因组测序 (Smith-Waterman) | 1 个 A100 | 1 个 H100

百亿亿次级高性能计算。

NVIDIA 数据中心平台性能持续提升,超越摩尔定律。H100 的全新突破性 AI 性能进一步加强了 HPC+AI 的力量,加速科学家和研究人员的探索,让他们全身心投入工作,解决世界面临的重大挑战。

H100 使双精度 Tensor Core 的每秒浮点运算 (FLOPS) 提升 3 倍,为 HPC 提供 60 teraFLOPS 的 FP64 浮点运算。融合 AI 的高性能计算应用可以利用 H100 的 TF32 精度实现 1 petaFLOP 的吞吐量,从而在不更改代码的情况下,实现单精度矩阵乘法运算。

H100 还采用 DPX 指令,其性能比 NVIDIA A100 Tensor Core GPU 高 7 倍,在动态编程算法(例如,用于 DNA 序列比对 Smith-Waterman)上比仅使用传统双路 CPU 的服务器快 40 倍。

加速数据分析。

在 AI 应用开发过程中,数据分析通常会消耗大部分时间。原因在于,大型数据集分散在多台服务器上,由仅配备商用 CPU 服务器组成横向扩展式的解决方案缺乏可扩展的计算性能,从而陷入困境。

搭载 H100 的加速服务器可以提供相应的计算能力,并利用 NVLink 和 NVSwitch 每个 GPU 3 TB/s 的显存带宽和可扩展性,凭借高性能应对数据分析以及通过扩展支持庞大的数据集。通过结合使用 NVIDIA Quantum-2 InfiniBand、Magnum IO 软件、GPU 加速的 Spark 3.0 和 NVIDIA RAPIDS™,NVIDIA 数据中心平台能够以出色的性能和效率加速这些大型工作负载。

为企业提高资源利用率。

IT 经理设法更大限度地提高数据中心计算资源的利用率(峰值和平均值)。他们通常会通过动态重新配置来合理调整计算资源,从而满足正在处理的工作负载的需求。

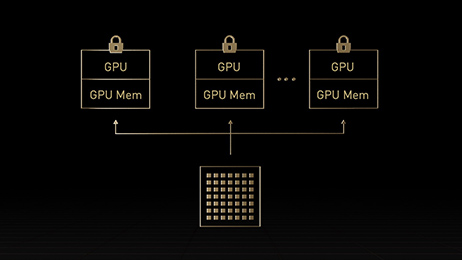

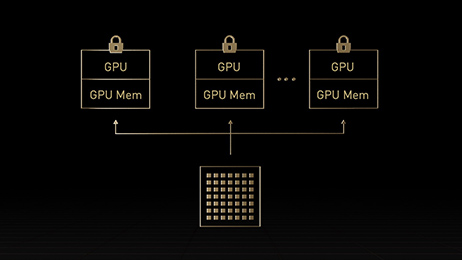

H100 中的第二代多实例 GPU (MIG) 技术通过安全地将每个 GPU 分为 7 个独立实例,更大限度地提高每个 GPU 的利用率。凭借机密计算支持,H100 可实现端到端多租户的安全使用,非常适合云服务提供商 (CSP) 环境。

使用支持 MIG 技术的 H100,基础架构管理员可对其 GPU 加速的基础架构作标准化处理,同时能够灵活地为 GPU 资源配置更精细的粒度,从而安全地为开发者提供正确的加速计算量,并确保其所有 GPU 资源得到充分利用。

内置机密计算。

当今的机密计算解决方案基于 CPU,对于 AI 和 HPC 等计算密集型工作负载来说,这些解决方案远远无法满足需求。NVIDIA 机密计算是 NVIDIA Hopper™ 架构的内置安全功能,该功能使 H100 成为 NVIDIA 率先推出的具有机密计算功能的加速器。用户可以在获取 H100 GPU 出色加速功能的同时,保护使用中的数据和应用的机密性和完整性。它创建了基于硬件的可信执行环境 (TEE),用于保护并隔离在单个 H100 GPU、节点内多个 H100 GPU 或单个 MIG 实例上运行的整个工作负载。在 TEE 内,GPU 加速应用的运行可以保持不变,且不必对其进行分区。用户可以将适用于 AI 和 HPC 的 NVIDIA 软件的强大功能与 NVIDIA 机密计算提供的硬件信任根的安全性相结合。

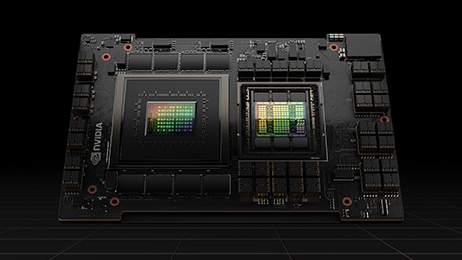

为大规模 AI 和高性能计算提供出色的性能。

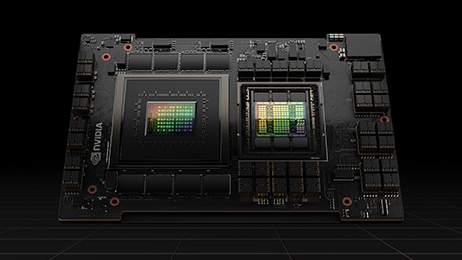

Hopper Tensor Core GPU 将为 NVIDIA Grace Hopper CPU+GPU 架构提供支持,该架构专为 TB 级加速计算而构建,可为大型 AI 和 HPC 提供 10 倍的性能。NVIDIA Grace CPU 利用 Arm® 架构的灵活性来创建 CPU 和服务器架构,该架构是专门针对加速计算而从头开始设计的。Hopper GPU 与 Grace CPU 搭配,使用 NVIDIA 超快速的芯片间互连技术,可提供 900GB/s 的带宽,比 PCIe 5.0 快 7 倍。与当今运行快的服务器相比,这种创新设计将 GPU 的聚合系统显存带宽提高 30 倍,并且会将运行数万亿字节数据的应用性能提高 10 倍。

外形规格:H100 PCIe

FP64:26 teraFLOPS

FP64 Tensor Core:51 teraFLOPS

FP32:51 teraFLOPS

TF32 Tensor Core:756teraFLOPS*

BFLOAT16 Tensor 1,513 teraFLOPS*

FP16 Tensor Core:1,513 teraFLOPS*

FP8 Tensor Core:3026 teraFLOPS*

INT8 Tensor Core:3026 TOPS*

GPU 显存:80GB

GPU 显存带宽:2TB/s

解码器:7 NVDEC 7 JPEG

大热设计功率 (TDP): 300-350 瓦(可配置)

多实例 GPU:多 7 个 MIG @每个 10GB

外形规格:PCIe双插槽风冷式

互连技术:NVLink:600GB/s PCIe 5.0:128GB/s

服务器选项:搭载 1 至 8 个 GPU 的合作伙伴系统及 NVIDIA 认证系统

NVIDIA AI Enterprise:已包含

戴尔服务器销售中心

戴尔服务器销售中心